Künstliche Intelligenz (KI) ist eine der transformativsten Technologien unserer Zeit. Sie verändert grundlegend, wie wir arbeiten, kommunizieren und leben. Mit der rasanten Verbreitung von KI-Systemen in kritischen Bereichen wie Gesundheitswesen, Justiz, Finanzwesen und Personalwesen wachsen jedoch auch die ethischen Bedenken. Dieser Artikel befasst sich mit den wichtigsten ethischen Überlegungen bei der Entwicklung und Implementierung von KI-Systemen und zeigt Wege auf, wie wir verantwortungsvoll mit dieser mächtigen Technologie umgehen können.

1. Warum ist KI-Ethik so wichtig?

KI-Systeme treffen zunehmend Entscheidungen, die direkte Auswirkungen auf Menschen haben – von der Bewertung der Kreditwürdigkeit über die Diagnose von Krankheiten bis hin zur Vorhersage kriminellen Verhaltens. Anders als bei herkömmlicher Software ist der Entscheidungsprozess bei KI-Systemen, insbesondere bei komplexen maschinellen Lernalgorithmen, oft nicht transparent und schwer nachvollziehbar.

Diese "Black Box"-Natur vieler KI-Systeme, kombiniert mit ihrer wachsenden Entscheidungsmacht, macht ethische Überlegungen zu einem zentralen Aspekt der KI-Entwicklung. Ohne angemessene ethische Leitlinien und Kontrollen besteht die Gefahr, dass KI-Systeme:

- Bestehende Vorurteile und Diskriminierungen verstärken oder verschärfen

- Die Privatsphäre und Autonomie der Menschen untergraben

- Ohne ausreichende Rechenschaftspflicht eingesetzt werden

- Zu unbeabsichtigten negativen Konsequenzen führen

— Prof. Dr. Maria Hoffmann, Ethikrat für Digitale Technologien"Die Frage ist nicht, ob wir KI regulieren sollten. Die Frage ist, wie wir sie regulieren, um ihre positiven Auswirkungen zu maximieren und gleichzeitig ihre Risiken zu minimieren."

2. Zentrale ethische Herausforderungen in der KI

Fairness und Vermeidung von Bias

KI-Systeme lernen aus Daten, und wenn diese Daten Vorurteile oder historische Ungerechtigkeiten widerspiegeln, kann die KI diese Muster erkennen und in ihren Entscheidungen reproduzieren. Beispiele für problematische Bias in KI-Systemen gibt es zahlreiche:

- Rekrutierungs-KI, die männliche Bewerber bevorzugt, weil historische Einstellungsdaten einen männlichen Bias aufweisen

- Gesichtserkennung, die bei Menschen mit dunklerer Hautfarbe weniger genau funktioniert

- Risikobewertungstools im Strafjustizsystem, die bestimmte demografische Gruppen systematisch benachteiligen

Die Herausforderung besteht darin, KI-Systeme zu entwickeln, die fair und unvoreingenommen entscheiden, selbst wenn die Trainingsdaten historische Vorurteile enthalten.

Transparenz und Erklärbarkeit

Viele moderne KI-Systeme, insbesondere Deep Learning-Modelle, funktionieren als "Black Box" – es ist schwer zu verstehen, wie sie zu bestimmten Entscheidungen kommen. Diese mangelnde Transparenz ist besonders problematisch in Hochrisikobereichen wie der medizinischen Diagnostik oder der Kreditvergabe.

Erklärbares KI (XAI) ist ein wachsendes Forschungsgebiet, das darauf abzielt, KI-Systeme transparenter und ihre Entscheidungen nachvollziehbarer zu machen. Dies ist nicht nur eine technische, sondern auch eine ethische Notwendigkeit – Menschen haben das Recht zu verstehen, warum eine KI eine bestimmte Entscheidung getroffen hat, die ihr Leben beeinflusst.

Erklärbare KI (XAI) macht Entscheidungsprozesse transparent

Privatsphäre und Datenschutz

KI-Systeme benötigen große Datenmengen, um zu lernen und zu funktionieren. Dies wirft Fragen zum Datenschutz und zur informationellen Selbstbestimmung auf. Wichtige Überlegungen umfassen:

- Wie werden Daten gesammelt, gespeichert und verwendet?

- Wie wird informierte Einwilligung sichergestellt?

- Wie kann man die Privatsphäre schützen und gleichzeitig nützliche KI-Anwendungen entwickeln?

- Wie verhindert man, dass KI-Systeme zur Massenüberwachung missbraucht werden?

Technologien wie federated learning, differential privacy und homomorphic encryption bieten vielversprechende Ansätze, um KI-Fortschritte mit Datenschutz in Einklang zu bringen.

Verantwortlichkeit und Rechenschaftspflicht

Wenn KI-Systeme Fehler machen oder Schaden verursachen, stellt sich die Frage: Wer ist verantwortlich? Der Entwickler, der Nutzer, das Unternehmen, das die KI einsetzt, oder sogar die KI selbst? Diese Frage der Verantwortlichkeit wird immer wichtiger, je autonomer KI-Systeme werden.

Die Einrichtung klarer Verantwortlichkeitsstrukturen und Rechenschaftspflichten ist entscheidend, um sicherzustellen, dass KI-Systeme verantwortungsvoll eingesetzt werden und dass es Rechtsmittel gibt, wenn etwas schiefgeht.

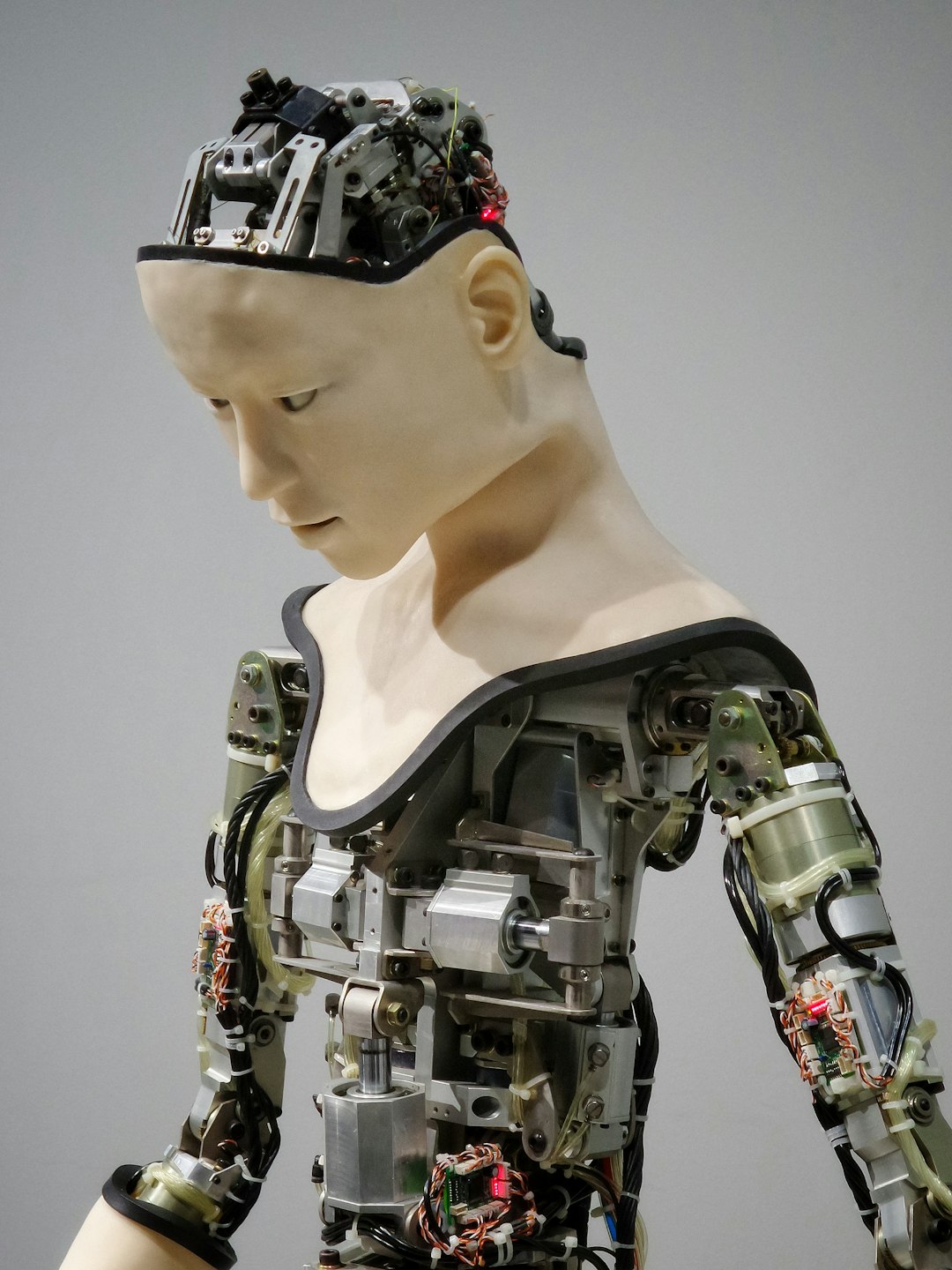

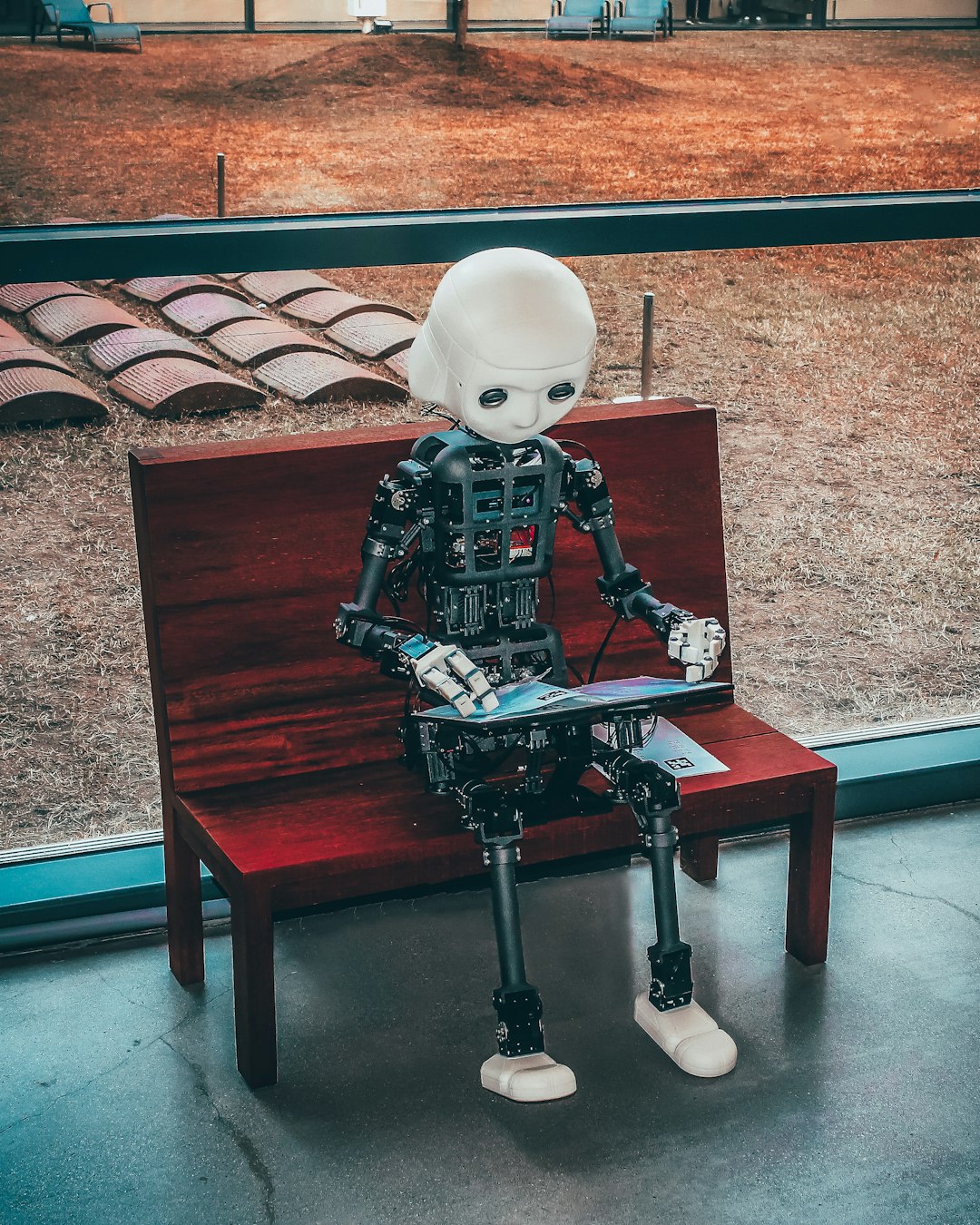

Autonomie und menschliche Kontrolle

Ein grundlegendes ethisches Prinzip ist, dass KI-Systeme die menschliche Autonomie und Entscheidungsfreiheit respektieren und fördern sollten, anstatt sie zu untergraben. Dies bedeutet:

- Menschen sollten die Möglichkeit haben, KI-Entscheidungen zu überstimmen

- KI sollte menschliche Fähigkeiten ergänzen, nicht ersetzen

- Bei kritischen Entscheidungen sollte immer ein "human in the loop" sein

- KI-Systeme sollten so gestaltet sein, dass sie menschliche Werte und Würde respektieren

Die vier Grundprinzipien der KI-Ethik

- Nutzen: KI sollte dem Wohl der Menschheit und des Planeten dienen

- Fairness: KI sollte gerecht, inklusiv und ohne systematische Benachteiligungen funktionieren

- Autonomie: KI sollte die menschliche Entscheidungsfreiheit und Kontrolle respektieren

- Erklärbarkeit: KI-Entscheidungen sollten transparent und nachvollziehbar sein

3. Praktische Ansätze für ethische KI

Wie können wir sicherstellen, dass KI-Systeme ethisch entwickelt und eingesetzt werden? Hier sind einige praktische Ansätze:

Diverse und repräsentative Daten

Ein wichtiger erster Schritt ist die Verwendung diverser und repräsentativer Trainingsdaten, die verschiedene demografische Gruppen, Perspektiven und Szenarien abdecken. Dies kann helfen, Bias zu reduzieren und fairere KI-Systeme zu entwickeln.

Dies bedeutet oft aktive Maßnahmen zur Sammlung inklusiver Daten und zur Korrektur bestehender Ungleichgewichte in historischen Datensätzen.

Bias-Erkennung und -Korrektur

Es gibt zunehmend Tools und Techniken zur Erkennung und Korrektur von Bias in KI-Systemen, darunter:

- Fairness-Metriken, die messen, ob ein Modell verschiedene Gruppen gleich behandelt

- Algorithmen zur Bias-Minderung während des Trainings

- Post-hoc-Anpassungen, um fairere Ergebnisse zu erzielen

Diese technischen Lösungen müssen jedoch mit einem tieferen Verständnis der zugrundeliegenden sozialen und ethischen Fragen kombiniert werden.

Ethik-by-Design

Ethische Überlegungen sollten von Anfang an in den Entwicklungsprozess von KI-Systemen integriert werden, nicht erst nachträglich. Dieser "Ethics-by-Design"-Ansatz beinhaltet:

- Frühzeitige Identifizierung potenzieller ethischer Risiken

- Integration ethischer Prinzipien in Designentscheidungen

- Kontinuierliche ethische Überprüfung während des Entwicklungsprozesses

- Einbeziehung diverser Perspektiven, einschließlich potenziell betroffener Communities

Ethik-Ausschüsse und -Richtlinien

Viele Organisationen richten spezielle Ethik-Ausschüsse ein, die KI-Projekte überprüfen und ethische Richtlinien entwickeln. Diese Gremien sollten interdisziplinär sein und Experten aus verschiedenen Bereichen wie Technik, Recht, Ethik, Soziologie und den jeweiligen Anwendungsdomänen umfassen.

Regulierung und Selbstregulierung

Die Regulierung von KI ist ein aktives politisches Thema. Die Europäische Union hat mit dem AI Act einen umfassenden Regulierungsrahmen vorgeschlagen, der KI-Anwendungen nach ihrem Risikoniveau kategorisiert und entsprechende Anforderungen festlegt.

Gleichzeitig entwickeln viele Unternehmen und Branchenverbände freiwillige Standards und Best Practices für den ethischen Einsatz von KI. Diese Selbstregulierung kann ein wichtiger Bestandteil eines umfassenden Governance-Ansatzes sein, sollte aber durch angemessene gesetzliche Rahmenbedingungen ergänzt werden.

4. Fallstudien: Ethische Herausforderungen in der Praxis

Gesichtserkennung und Überwachung

Gesichtserkennungstechnologie wirft erhebliche ethische Bedenken auf, insbesondere in Bezug auf Privatsphäre, Überwachung und potenzielle Diskriminierung. Mehrere Städte haben den Einsatz dieser Technologie durch Behörden eingeschränkt, und große Technologieunternehmen haben Moratorien für den Verkauf von Gesichtserkennung an Strafverfolgungsbehörden verhängt.

Dieser Fall illustriert die Spannung zwischen technologischem Fortschritt und dem Schutz grundlegender Rechte und zeigt, dass manchmal die ethischste Entscheidung sein kann, eine Technologie nicht einzusetzen.

KI in der Gesundheitsversorgung

KI hat enormes Potenzial, die Gesundheitsversorgung zu verbessern, von der Diagnose von Krankheiten bis hin zur Entwicklung neuer Medikamente. Gleichzeitig gibt es wichtige ethische Überlegungen:

- Wie wird der Datenschutz sensibler Gesundheitsdaten gewährleistet?

- Wie verhindert man, dass KI-Diagnosetools bestehende Gesundheitsungleichheiten verstärken?

- Welche Rolle sollten Ärzte versus KI-Systeme bei klinischen Entscheidungen spielen?

Die Lösung liegt oft in einem hybriden Ansatz, bei dem KI menschliche Expertise ergänzt, anstatt sie zu ersetzen, und in robusten Datenschutz- und Fairnessmaßnahmen.

Autonome Fahrzeuge

Selbstfahrende Autos stehen vor komplexen ethischen Dilemmata, wie dem berühmten "Trolley-Problem": Wie soll ein autonomes Fahrzeug entscheiden, wenn es zwischen verschiedenen schädlichen Ergebnissen wählen muss?

Diese Fälle zeigen, dass KI-Ethik nicht nur abstrakte Prinzipien betrifft, sondern konkrete Entscheidungen mit realen Konsequenzen.

5. Die Zukunft der KI-Ethik

Die ethischen Herausforderungen der KI werden mit der Weiterentwicklung der Technologie zunehmen. Neue Themen wie das Bewusstsein künstlicher Intelligenz, KI-Rechte und die langfristigen gesellschaftlichen Auswirkungen hochentwickelter KI-Systeme könnten in Zukunft an Bedeutung gewinnen.

Ein proaktiver, inklusiver und internationaler Ansatz zur KI-Ethik ist entscheidend, um sicherzustellen, dass diese mächtige Technologie zum Wohle der Menschheit eingesetzt wird. Dies erfordert die Zusammenarbeit verschiedener Stakeholder – Technologieentwickler, politische Entscheidungsträger, Wissenschaftler, Ethiker und die breitere Gesellschaft.

Fazit: Der Weg zu einer ethischen KI

Die ethische Entwicklung und der verantwortungsvolle Einsatz von KI sind keine optionalen Extras, sondern wesentliche Voraussetzungen für das langfristige Vertrauen in und den Erfolg von KI-Systemen. Durch die Berücksichtigung ethischer Prinzipien wie Fairness, Transparenz, Privatsphäre und menschliche Autonomie können wir KI-Technologien schaffen, die nicht nur leistungsfähig, sondern auch vertrauenswürdig und zum Wohle aller sind.

Als Gesellschaft stehen wir vor der bedeutsamen Aufgabe, die Entwicklung der KI so zu steuern, dass sie unsere grundlegenden Werte widerspiegelt und verstärkt. Dies erfordert kontinuierlichen Dialog, kritisches Denken und den Willen, manchmal kurzfristige technologische Vorteile zugunsten langfristiger ethischer Überlegungen zurückzustellen.

Letztendlich geht es nicht darum, ob wir KI entwickeln sollten, sondern wie wir sie entwickeln – auf eine Weise, die das Beste der menschlichen Werte und Bestrebungen verkörpert.

Kommentare (4)

Laura Müller

22. März 2024, 09:30Exzellenter Artikel! Als IT-Beraterin bin ich oft mit ethischen Fragen bei der Implementierung von KI-Lösungen konfrontiert. Die Diskussion über Transparenz und Erklärbarkeit ist besonders wichtig – wir können nicht einfach "Black Box"-Systeme in kritischen Bereichen einsetzen.

Michael Schmidt

22. März 2024, 14:15Ich stimme zu, dass ethische Überlegungen von Anfang an in den Entwicklungsprozess integriert werden müssen. Als Entwickler habe ich die Erfahrung gemacht, dass nachträgliche "ethische Korrekturen" oft schwierig und ineffizient sind.

Thomas Weber

23. März 2024, 10:45Die Diskussion über autonome Fahrzeuge und das Trolley-Problem ist faszinierend. Es zeigt, wie KI uns zwingt, moralische Fragen zu formalisieren, die wir Menschen oft intuitiv oder situativ entscheiden.

Sophia König

24. März 2024, 16:20Ich arbeite im Gesundheitswesen und sehe täglich die Spannungen zwischen Innovation und ethischen Bedenken. Die Balance zu finden ist nicht einfach, aber essentiell. Danke für diesen differenzierten Beitrag!

Hinterlassen Sie einen Kommentar